Fairouz Malek, Responsable Scientifique du Projet LCG-France

(Mise à jour : 20/12/2012)

Lors de la prise de données du LHC dans les années 2011 et 2012, les quatre expériences (ALICE, ATLAS, CMS, LHCb) ont enregistré chaque année près de 1010 collisions, ce dernier chiffre est comparable au nombre d’étoiles dans la Voie Lactée. Traiter les données ainsi accumulées, représente un véritable défi informatique autant pour les flux (de l’ordre du GigaOctets par seconde) que pour leur volume (plusieurs dizaines de PetaOctets chaque année). A tout instant, quelques milliers de chercheurs du monde entier solliciteront des ressources de calcul et de stockage pour analyser ces données. Pour faire face à ce défi, la solution du calcul distribué, ou grille de calcul, s’est imposée. Le principe de la grille W-LCG s’appuie sur des centres de calcul répartis dans le monde entier et qui sont organisés en réseau.

Lorsqu’une requête est formulée par un utilisateur à partir de l’un des nombreux points d’entrée du système, la grille de calcul établit l’identité de l’utilisateur, vérifie ses autorisations, recherche les sites disponibles et susceptibles de fournir les ressources requises, en termes de stockage, de capacité de calcul, de disponibilité des logiciels d’analyse… pour finalement satisfaire la requête de l’utilisateur sans que ce dernier ait à se soucier du détail du processus. La grille W-LCG est hiérarchisée en quatre niveaux, ou rangs, appelés « Tier ». L’appartenance à un rang donné fixe la nature et la qualité des services qu’un centre de calcul doit fournir. La quantité de ressources à fournir est à la discrétion des agences de financement selon un protocole d’accord rediscuté chaque année (MoU WLCG).

Pour traiter l’ensemble des données enregistrées par les expériences du LHC, les besoins en capacité de calcul atteints en 2012 sont de plus de 1 Million kHS06-heure/mois (plus de 2 million de jobs par jour ou l'équivalent de 500 000 ordinateurs de bureau modernes) et plus de 200 PB (1pétaoctet = 1015 octets ) de disk. Actuellement, la grille W-LCG compte près de 200 sites répartis sur 4 continents: 1Tier 0 (CERN); 11 Tier1 (1 Taiwan, 2 US, 1 CAN, 7 EU); 68 fédérations de Tier2.

Des réseaux haut débit, de 10 Goctets/s ou plus, spécialement conçus pour le LHC, LHCOPN (LHC Optical Private Network), connectent le centre Tier0 aux centres Tier1. Ils assurent le transit des données venant des expériences et des données de physique traitées à un taux de 800 Moctets/s. Les centres Tier2 sont connectés aux Tier1 par des réseaux de l’ordre du Goctet/s ou plus.

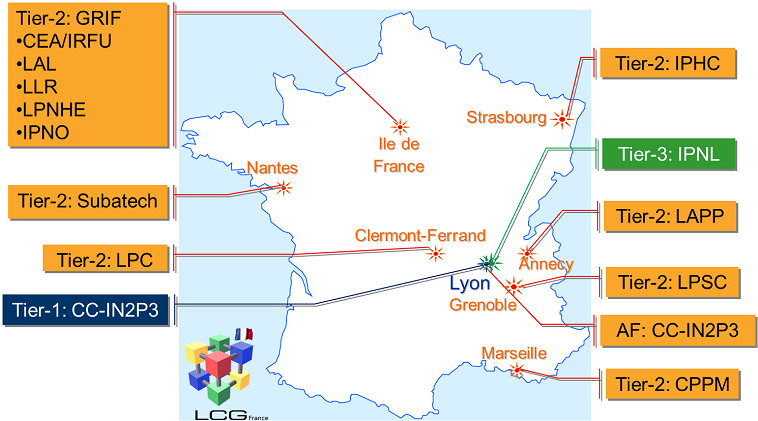

La France héberge l’un des 11 centres Tier1 de W-LCG au Centre de Calcul de l'IN2P3 à Villeurbanne (CC-IN2P3)et plusieurs sites de niveau Tier2 et Tier3 : Ile-de-France, Clermont-Ferrand, Lyon, Nantes, Annecy, Grenoble, Strasbourg, Marseille. La gestion de ces ressources, le fonctionnement, le financement et les relations avec W-LCG sont assurés par le projet LCG-France crée en 2004. A Grenoble, le site Tier2 sert les deux expériences LHC, ALICE et ATLAS.

Le CC-IN2P3, financé conjointement par l’IN2P3 du CNRS et l’IRFU du CEA, offre ses services et ressources aux quatre expériences du LHC à hauteur de 10% de l’effort mondial en CPU des Tier1. Le CC-IN2P3 héberge également un Tier2 et un Tier3 regroupés sous l’appellation de « ferme d’analyse » ou AF. Une partie des ressources des sites Tier2 hors CC-IN2P3 est également dédiée à l’analyse type Tier3 (end-user analysis). Un seul site, GRIF en Ile de France, est une fédération de plusieurs sites Tier2/Tier3. La contribution CPU relative de la France à l’effort mondial des Tier2 est voisine de 10%.

Plus de détails peuvent se trouver dans les divers sites webs de LCG :

- MoU W-LCG : http://wlcg.web.cern.ch/

- LCG-France : http://lcg.in2p3.fr/

- LPSC Tier2 Site