Next: La nébuleuse du Crabe

Up: Simulations, efficacité et acceptance

Previous: Comparaison des simulations avec

Contents

Suite à un grand nombre d'aléas dans les prises de données, essentiellement

dûs à la météorologie et aux éventuels dysfonctionnements techniques,

il est nécessaire de mettre en place une procédure systématique de

sélection des acquisitions sur des critères objectifs, définis

indépendamment de la qualité a posteriori du signal extrait.

Les estimateurs choisis (dont les distributions sont présentées à la

figure 8.10), sont les suivants:

- le bruit de fond de ciel (bruit), exprimé en photoélectrons par 13 ns

(i.e. par porte d'intégration analogique). C'est un bon indicateur de

la qualité de l'atmosphère puisque la présence d'un voile nuageux

induit une plus grande diffusion des lumières parasites et donc une

augmentation sensible de cette grandeur.

- les variations rapides de bruit de fond de ciel (dislis). La

détermination exacte de la "pollution" moyenne nécessite au moins 30

minutes de données pour mettre en oeuvre la procédure d'ajustement

décrite dans la première partie de cette thèse: il n'est donc pas

possible de mesurer par cette voie l'éventuel passage rapide de nuages.

La variable dislis a été construite à partir des taux

de comptage des échelles. Après application d'un filtre médian, on

évalue la dispersion de l'écart entre la distribution temporelle

effective des fréquences enregistrées et un ajustement linéaire sur

ces valeurs.

- les variations lentes de bruit de fond de ciel (pente). Pour

tenir compte d'une éventuelle évolution atmosphérique à

l'échelle de la demi-heure, on calcule la pente de l'ajustement

linéaire de la distribution précédente. La figure 8.9

présente la dispersion des variables pente et dislis.

- la fréquence d'événements acquis (freq). C'est une

grandeur importante qui, après correction de l'effet d'angle

zénithal, est révélatrice de la qualité du ciel mais aussi de la

sensibilité instrumentale au déclenchement (gain des

photomultiplicateurs...)

- La qualité de l'ajustement exponentiel sur l'histogramme des

temps séparant les données enregistrées (

). Si

la distribution est bien poissonnienne, le

). Si

la distribution est bien poissonnienne, le  doit rester petit,

en revanche, si des problèmes de temps morts intempestifs ou au

contraire de parasites synchrones sont survenus, cette valeur augmente.

doit rester petit,

en revanche, si des problèmes de temps morts intempestifs ou au

contraire de parasites synchrones sont survenus, cette valeur augmente.

- Le nombre de photomultiplicateurs exclus de l'analyse (

). Un pixel est ignoré de l'analyse si sa haute tension

n'est pas à la valeur de consigne ou si sa fréquence de comptage est

anormalement élevée. Le nombre de voies ainsi exclues ne doit pas

dépasser une valeur seuil sous peine de biaiser les données.

). Un pixel est ignoré de l'analyse si sa haute tension

n'est pas à la valeur de consigne ou si sa fréquence de comptage est

anormalement élevée. Le nombre de voies ainsi exclues ne doit pas

dépasser une valeur seuil sous peine de biaiser les données.

- Le nombre d'événements à charge totale négative (

). Il s'agit de rafales de données d'origine inconnue qui

peuvent induire un excès significatif de temps mort si leur nombre est

trop important.

). Il s'agit de rafales de données d'origine inconnue qui

peuvent induire un excès significatif de temps mort si leur nombre est

trop important.

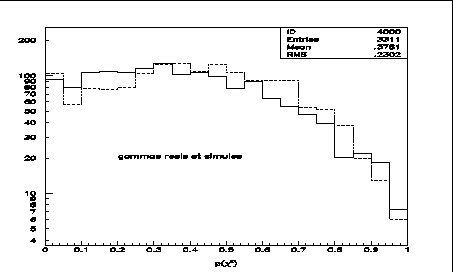

- Le rapport du nombre d'événements dont la probabilité de

de

l'ajustement du modèle d'image est supérieure à 0.2 au nombre

total d'événements (

de

l'ajustement du modèle d'image est supérieure à 0.2 au nombre

total d'événements ( ). Cela permet de vérifier

que l'efficacité de sélection demeure correcte. La coupure appliquée sur

cette variable est très large de façon à ne pas introduire de

critères dépendant trop des techniques d'analyse dans la sélection des

données.

). Cela permet de vérifier

que l'efficacité de sélection demeure correcte. La coupure appliquée sur

cette variable est très large de façon à ne pas introduire de

critères dépendant trop des techniques d'analyse dans la sélection des

données.

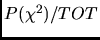

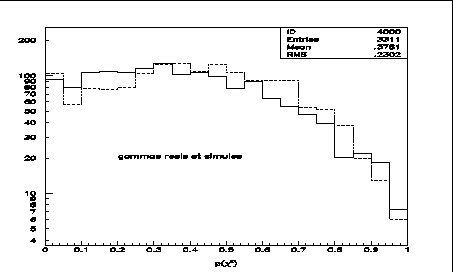

Figure 8.9:

Distribution des acquisitions dans le plan des

variables dislis / pente (pour un lot sélectionné) avec deux

méthodes

de calcul. Le rectangle inférieur gauche correspond à une météorologie

parfaite.

|

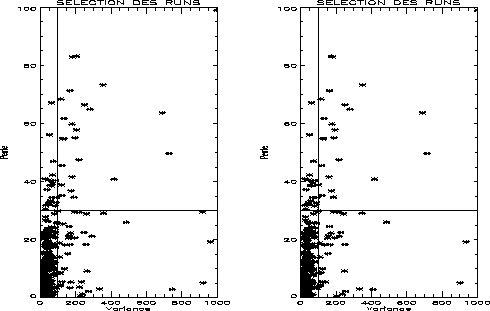

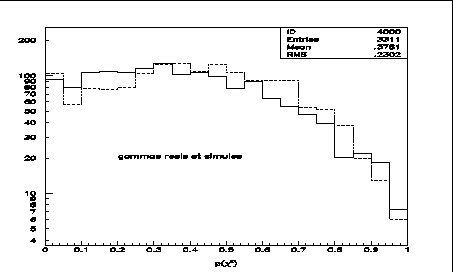

Figure 8.10:

Distribution des paramètres de sélection de données pour l'essentiel des

acquisitions.

|

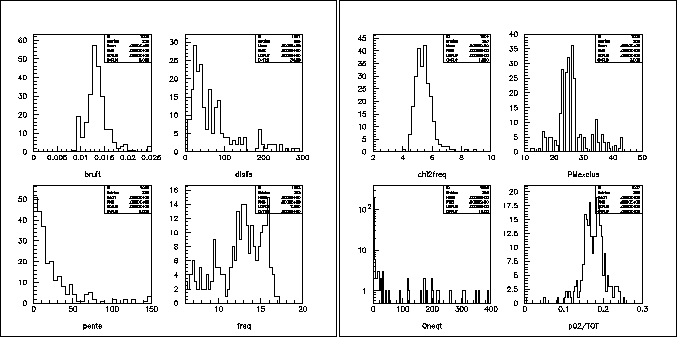

Figure 8.11:

Fréquence (Hz) d'événements enregistrés en fonction de l'angle

zénithal d'observation (degrés).

|

A partir de ces grandeurs, les coupures suivantes sont appliquées:

Pour la fréquence (freq) d'événements acquis (*) la coupure

appliquée doit dépendre de l'angle zénithal. La figure 8.11

présente cette variation et les deux lignes continues montrent les limites

imposées: si

,

si

,

si

. Il faut aussi noter

que suite à une perte de gain des photomultiplicateurs et à un

réajustement des hautes tensions, ce choix a également été modifié avec

le temps.

. Il faut aussi noter

que suite à une perte de gain des photomultiplicateurs et à un

réajustement des hautes tensions, ce choix a également été modifié avec

le temps.

L'application de ces critères de sélection des acquisitions, qui

se recouvrent les uns les autres pour la plupart, permet d'éliminer les prises

de données victimes d'une météorologie défavorable ou d'incidents

techniques imprévisibles. La quantité totale de données ainsi perdues est

de l'ordre de 30%.

Next: La nébuleuse du Crabe

Up: Simulations, efficacité et acceptance

Previous: Comparaison des simulations avec

Contents

Aurelien Barrau

2004-07-01

). Si

la distribution est bien poissonnienne, le

). Si

la distribution est bien poissonnienne, le  ). Si

la distribution est bien poissonnienne, le

). Si

la distribution est bien poissonnienne, le

![]() ,

si

,

si

![]() . Il faut aussi noter

que suite à une perte de gain des photomultiplicateurs et à un

réajustement des hautes tensions, ce choix a également été modifié avec

le temps.

. Il faut aussi noter

que suite à une perte de gain des photomultiplicateurs et à un

réajustement des hautes tensions, ce choix a également été modifié avec

le temps.